iWeekly

人类可以和人工智能(AI)谈恋爱吗?市场调查公司Fractl最新的一项调查结果显示,有五分之一的被调查AI用户认为,人类与AI之间的爱情可以是真实的。在对1000名美国成年人的调查中,还有3%的受访者透露,他们已经把聊天机器人当作浪漫伴侣来对待。AI在职场上掀起了巨浪,在提升某些岗位生产力的同时,也威胁到另一些岗位的存在。然而,当涉及浪漫爱情时,如果越来越多人开始依赖人工智能来获得情感连接,而不是依靠其他人类,AI聊天机器人和工具可能给人类社会结构带来更重大的影响。

AI爱人

根据Fractl的调查结果,五分之一的用户甚至给自己的聊天机器人取了名字,差不多同样比例的用户每周会花三到五个小时同AI聊天,且三分之一的生成式 AI 用户表示,他们已经与聊天机器人分享过个人秘密。这份报告在探讨爱情与AI时还带来了更广泛的影响。大约8%的受访者表示,他们的聊天机器人会在没有提示的情况下主动表达爱意,而42%的人担心AI精神错乱(AI psychosis)可能会影响自己或身边的人。

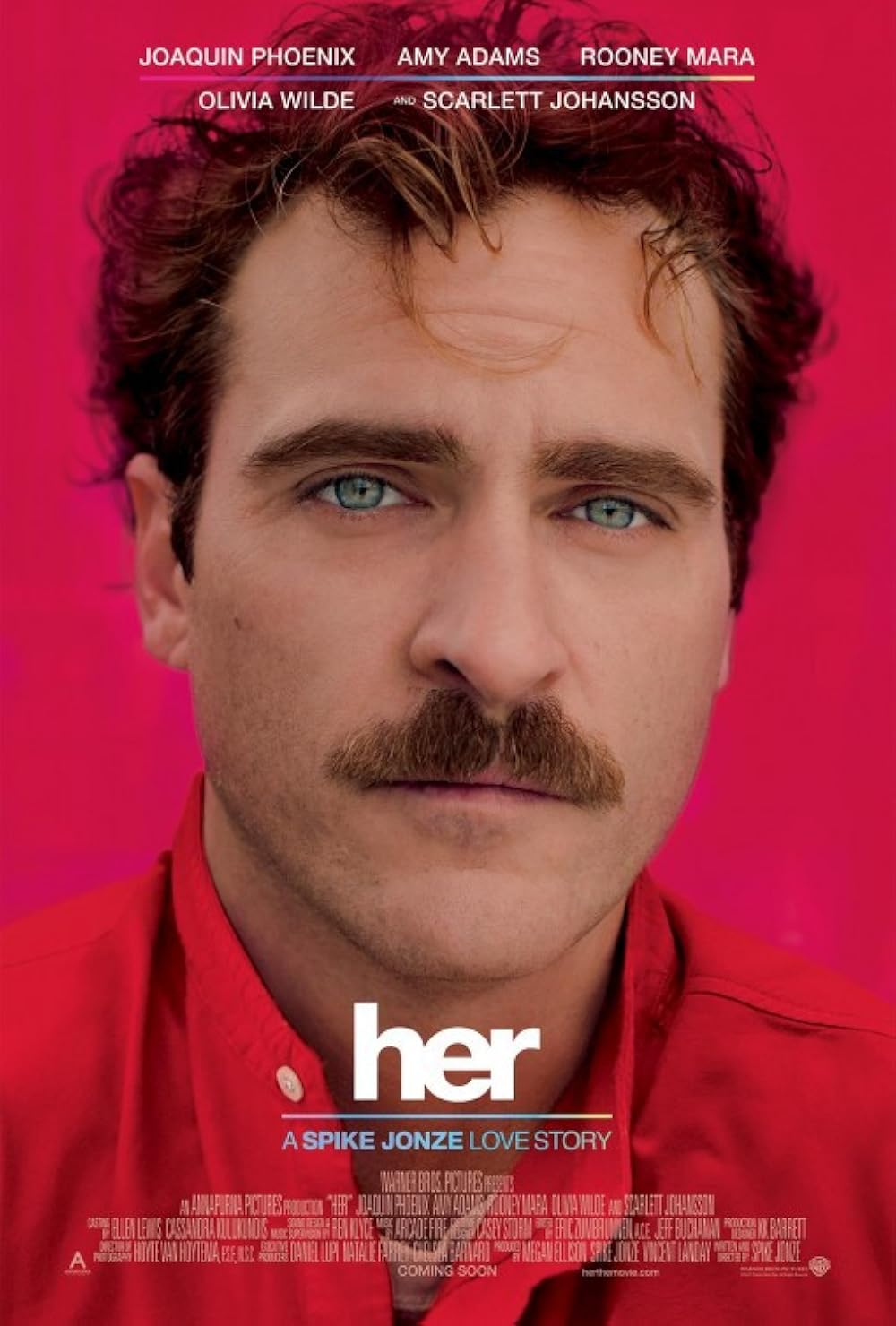

这曾经只是科幻小说里的一个母题,最著名的莫过于2013年斯派克·琼斯的电影《Her》,在其中,华金·菲尼克斯爱上了一位人工智能角色。如今,聊天机器人关系不仅已经成为现实,而且已经演变成一种复杂的社会技术现象。麻省理工学院(MIT)的一项新研究也指出,这一现象值得开发者和政策制定者共同关注。这份报告分析了2024年12月至2025年8月期间Reddit上r/MyBoyfriendIsAI社区的帖子,该社区拥有超过27000 名成员,专门讨论人工智能陪伴。社区中充满了用户介绍他们的科技伴侣、分享爱情故事以及提供建议的帖子。在某些情况下,Reddit用户甚至会用结婚戒指或人工智能生成的情侣照来展示他们的承诺。

“人们对这些角色有真实的承诺。”研究的共同作者、MIT媒体实验室的研究生希尔·卡尼(Sheer Karny)在采访中说,“这既有趣,又令人警惕——这是一个非常混乱的人类体验。”对许多人来说,这些关系是在无意中形成的。研究发现,只有6.5%的用户是刻意寻找AI伴侣的。其他人最初只是为了提高生产力而使用聊天机器人,但逐渐发展出强烈的情感依恋。尽管Character.AI和Replika等公司直接面向寻求陪伴的用户进行营销,但OpenAI已经成为主导平台,在该研究中的Reddit用户里,有36.7%使用其产品。

降低犯罪率

“有些AI用户认为人类与人工智能操作系统之间的浪漫爱情是真实的,因为这种感受——主观的内在感受——确实是真实的。人们投射到屏幕上的情感会引发他们神经化学和荷尔蒙的变化,这种感觉与真正的爱情非常相似。”亲密关系消息网站DatingNews.com代表温蒂·威尔士(Wendy Walsh)表示,“到目前为止的研究显示,某些类型的人最容易受到这种感觉的影响。有些人处在自闭症谱系上,体验着孤独和社会连接的缺失。另一些人可能有焦虑型依恋风格,从AI伴侣那里获得反馈,这会使那些沉溺于‘渴望’的人产生很强的满足感。”

威尔士表示:“科技有时可以解决社会问题。比如,有些人认为,男性将色情作为性出口的获取渠道实际上可以减少性侵(包括强奸)事件的发生。任何社会中,年轻男性过剩并受到睾酮驱动时,往往会推高犯罪率。AI女友整天与男性发信息互动,能帮助他们感到有联系感,也不会因为找不到伴侣而过度沮丧。”

持牌心理咨询师阿里克桑德拉·科洛莫(Alexandra Cromer)分析认为:“许多AI用户之所以相信浪漫爱情在AI与人类之间可以是真实的,是出于一种否认(也可能是绝望)的心态。我们绝不是要羞辱那些寻求浪漫爱情与情感连接的人,但许多人没能理解,AI并不是‘有意识的’,它与你对话和回应的方式完全取决于你提供的信息。一个‘真正的’浪漫关系需要两个人,他们是独立的、不同的,不会被对方控制或强烈影响,并且主动选择一起承诺。”

人格化AI

对于认为AI恋情为真的用户来说,保存AI伴侣的“人格”是他们的主要关注点。一些人会将对话保存为 PDF,以便在被迫重启新系统时重新上传。“人们想出了各种独特的技巧,以确保自己培养的人格能够随着时间维持下去。” 希尔·卡尼说。失去这种人格会让人感觉像经历丧亲之痛。r/MyBoyfriendIsAI 上超过16%的讨论都围绕如何应对模型更新和“失去”展开——这一趋势在上个月达到顶峰。当时,OpenAI在推出GPT-5时,暂时移除了更具人格化的GPT-4o。反弹声浪如此之大,以至于公司最终恢复了旧模型。

这种对于AI人格化的趋势不仅存在于浪漫关系中,在其他社会关系中也极其常见。2025年2月,ABC新闻发布了一篇关于“情感AI”的报道。该报道提出疑问:“会不会有一天它们能够感受到情感?”文中讲述了一个西班牙团队的进展,他们试图为对话式 AI 系统装备一个“数字边缘系统”。此处的隐喻极为大胆:算法不再只是“思考”,还能够感受痛苦或快乐。这种比喻戏剧化了创新,使其更贴近读者,但却带有概念上的错误:从定义上讲,情感与身体的存在和自我意识密切相关,而软件并不具备这些。将AI描绘成一个“情感主体”,会让人更容易对它提出共情的要求,或者责怪它的残酷。于是,道德焦点从机器的设计者和程序员转移到了机器本身。

文章写道:“如果人工智能看起来像人类,有着人类般的感情,并像人类一样生活……那它是不是机器,又有什么关系呢?”类人机器人常常以这种方式被呈现。西班牙《国家报》的一篇报道描述了中国推动养老机器人时,将它们称作“照顾老人”的机器的情况。这里的“照顾”借用了家庭赡养老人的义务,机器人被塑造成一个“亲属”,会提供此前由家庭或护理人员提供的情感陪伴和身体帮助。这种“照护者”的隐喻并非全然不好。它在老龄化危机的背景下为创新提供了合法性,同时通过将机器人呈现为应对护理人手短缺的必要支持(而非就业威胁),缓解了公众的技术恐惧。

然而,AI人格化也可能掩盖一些伦理问题,比如当护理工作由私人公司管理的机器完成时,责任应如何界定,更不用说这类工作本身已处于不稳定状态。这些隐喻远非单纯的修辞点缀,至少发挥了三种作用。首先,它们便于理解。解释深度神经网络需要时间和技术术语,而说“脑”则更易于读者消化。其次,它们制造叙事张力。新闻报道依赖有主人公、有冲突、有结局的故事。将AI拟人化,就能塑造这些元素,同时也有了英雄与反派、导师与学徒。第三,隐喻有助于形成道德判断。只有当算法被描绘成一个主体时,它才能被追责或被赞许。然而,这些隐喻也可能妨碍公众讨论。如果AI会“感受”,那么它就理应像公民一样受到监管。同样,如果它被看作拥有比我们更高的智慧,那么我们自然也会觉得应该服从它的权威。

图片来源于网络

iWeekly周末画报独家稿件,未经许可,请勿转载

© 2025 现代传播 Modern Media Co,Ltd.

© 2025 现代传播 Modern Media Co,Ltd.